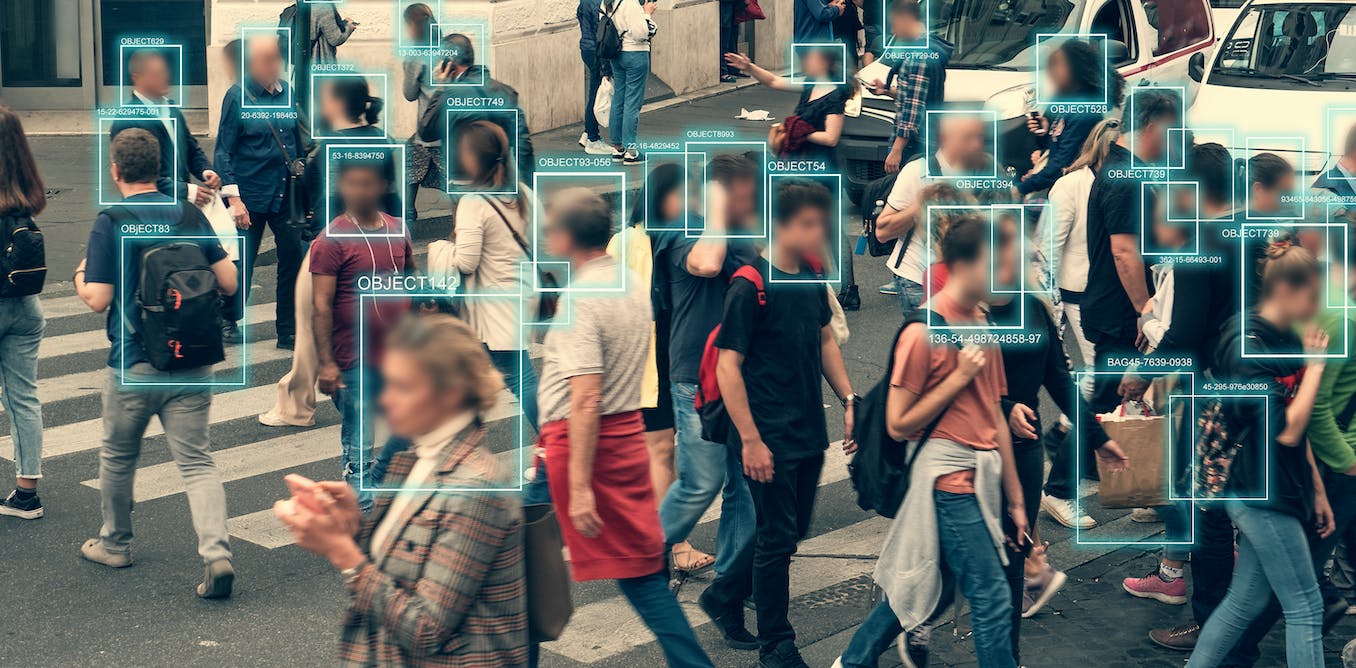

De wet van de EU'zal in het algemeen het gebruik van real-time gezichtsherkenning in openbare ruimtes verbieden. DedMityay / Shutterstock

Het woord “risico” komt tegenwoordig vaak voor in dezelfde zin als “kunstmatige intelligentie”. Hoewel het bemoedigend is om te zien dat wereldleiders nadenken over de mogelijke problemen van AI, samen met de industriële en strategische voordelen, moeten we niet vergeten dat niet alle risico’s gelijk zijn.

Op woensdag 14 juni stemde het Europees Parlement voor de goedkeuring van zijn eigen ontwerpvoorstel voor de AI Act, een stuk wetgeving dat twee jaar in de maak is en dat de ambitie heeft om wereldwijde normen voor de regulering van AI te vormen.

Na een laatste fase van onderhandelingen om de verschillende ontwerpen van het Europees Parlement, de Commissie en de Raad met elkaar in overeenstemming te brengen, zou de wet voor het einde van het jaar moeten worden goedgekeurd. Het wordt de eerste wetgeving ter wereld die AI in bijna alle sectoren van de samenleving reguleert – hoewel defensie hiervan is uitgezonderd.

Van alle manieren waarop je AI-regulering zou kunnen benaderen, is het de moeite waard om op te merken dat deze wetgeving volledig is geframed rond het begrip risico. Het is niet de AI zelf die wordt gereguleerd, maar eerder de manier waarop het wordt gebruikt in specifieke domeinen van de samenleving, die elk verschillende potentiële problemen met zich meebrengen. De vier risicocategorieën, waarvoor verschillende wettelijke verplichtingen gelden, zijn: onaanvaardbaar, hoog, beperkt en minimaal.

Systemen die geacht worden een bedreiging te vormen voor fundamentele rechten of EU-waarden, worden gecategoriseerd als systemen met een “onaanvaardbaar risico” en worden verboden. Een voorbeeld van zo’n risico zijn AI-systemen die worden gebruikt voor “predictive policing”. Dit is het gebruik van AI om risicobeoordelingen te maken van individuen, gebaseerd op persoonlijke informatie, om te voorspellen of ze waarschijnlijk misdaden zullen plegen.

Een meer controversieel geval is het gebruik van gezichtsherkenningstechnologie op live beelden van straatcamera’s. Dit is ook toegevoegd aan de lijst van verdachte personen. Dit is ook toegevoegd aan de lijst van onaanvaardbare risico’s en zou alleen worden toegestaan na het plegen van een misdrijf en met gerechtelijke toestemming.

De systemen die zijn geclassificeerd als “hoog risico” zullen worden onderworpen aan openbaarmakingsverplichtingen en zullen naar verwachting worden geregistreerd in een speciale database. Ze zullen ook onderworpen zijn aan verschillende monitoring- of auditvereisten.

De soorten toepassingen die als “hoog risico” zullen worden geclassificeerd, omvatten AI die de toegang tot diensten in het onderwijs, de arbeidsmarkt, financiering, gezondheidszorg en andere kritieke gebieden zou kunnen controleren. Het gebruik van AI op dergelijke gebieden wordt niet als onwenselijk gezien, maar toezicht is essentieel omdat het de veiligheid of fundamentele rechten negatief kan beïnvloeden.

Het idee is dat we erop moeten kunnen vertrouwen dat software die beslissingen neemt over onze hypotheek, zorgvuldig wordt gecontroleerd op naleving van Europese wetten om ervoor te zorgen dat we niet worden gediscrimineerd op basis van beschermde kenmerken zoals geslacht of etnische achtergrond – tenminste als we in de EU wonen.

AI-systemen met een “beperkt risico” zullen worden onderworpen aan minimale transparantie-eisen. Ook exploitanten van generatieve AI-systemen – bijvoorbeeld bots die tekst of afbeeldingen produceren – moeten bekendmaken dat de gebruikers interactie hebben met een machine.

Tijdens de lange reis door de Europese instellingen, die begon in 2019, is de wetgeving steeds specifieker en explicieter geworden over de potentiële risico’s van het inzetten van AI in gevoelige situaties – samen met hoe deze kunnen worden gecontroleerd en beperkt. Er moet nog veel werk worden verzet, maar het idee is duidelijk: we moeten specifiek zijn als we dingen voor elkaar willen krijgen.

Risico op uitsterven?

Daarentegen hebben we onlangs petities gezien die oproepen tot het verminderen van een verondersteld “risico van uitsterven” dat AI met zich meebrengt, zonder verdere details te geven. Verschillende politici hebben deze standpunten herhaald. Dit algemene risico op zeer lange termijn is heel anders dan wat de AI-wet vormgeeft, omdat het geen details geeft over waar we voor moeten uitkijken, noch wat we nu moeten doen om ons ertegen te beschermen.

Als “risico” de “verwachte schade” is die ergens uit kan voortvloeien, dan doen we er goed aan om ons te richten op mogelijke scenario’s die zowel schadelijk als waarschijnlijk zijn, omdat deze het hoogste risico inhouden. Zeer onwaarschijnlijke gebeurtenissen, zoals een botsing van een asteroïde, zouden geen voorrang moeten krijgen op meer waarschijnlijke gebeurtenissen, zoals de effecten van vervuiling.

Generieke risico’s, zoals de mogelijkheid dat mensen uitsterven, worden niet genoemd in de wet.

Zsolt Biczo / Shutterstock

In die zin heeft de ontwerpwetgeving die zojuist is goedgekeurd door het EU-parlement minder flitsend maar meer inhoud dan sommige van de recente waarschuwingen over AI. Het probeert de dunne lijn te bewandelen tussen het beschermen van rechten en waarden, zonder innovatie te verhinderen, en richt zich specifiek op zowel gevaren als remedies. Hoewel het verre van perfect is, biedt het in ieder geval concrete maatregelen.

De volgende fase in de reis van deze wetgeving zijn de trilogen – driezijdige dialogen – waar de afzonderlijke ontwerpen van het parlement, de commissie en de raad zullen worden samengevoegd tot een definitieve tekst. Naar verwachting zullen er in deze fase compromissen worden gesloten. De resulterende wet zal in werking treden, waarschijnlijk eind 2023, voordat de campagne voor de volgende Europese verkiezingen begint.

Na twee of drie jaar wordt de wet van kracht en moet elk bedrijf dat binnen de EU actief is eraan voldoen. Deze lange tijdlijn stelt ons wel voor een aantal vragen, want we weten niet hoe AI, of de wereld, eruit zal zien in 2027.

Laten we niet vergeten dat de voorzitter van de Europese Commissie, Ursula von der Leyen, deze verordening voor het eerst voorstelde in de zomer van 2019, vlak voor een pandemie, een oorlog en een energiecrisis. Dit was ook voordat ChatGPT politici en de media regelmatig aan het praten kreeg over een existentieel risico van AI.

De wet is echter zo algemeen geschreven dat hij nog wel even relevant kan blijven. Het zal mogelijk van invloed zijn op de manier waarop onderzoekers en bedrijven AI benaderen buiten Europa.

Wat wel duidelijk is, is dat elke technologie risico’s met zich meebrengt en in plaats van te wachten tot er iets negatiefs gebeurt, proberen academische en beleidsinstellingen vooruit te denken over de gevolgen van onderzoek. Vergeleken met de manier waarop we eerdere technologieën hebben overgenomen – zoals fossiele brandstoffen – betekent dit een zekere vooruitgang.

Nello Cristianini is de auteur van "The Shortcut: Waarom intelligente machines niet denken zoals wij", uitgegeven door CRC Press, 2023.