De hoeveelheid informatie online is overweldigend. Shyntartanya

Van de COVID-19 pandemie tot de oorlog in Oekraïne, misinformatie is wereldwijd aan de orde van de dag. Er zijn veel hulpmiddelen ontworpen om mensen te helpen verkeerde informatie te herkennen. Het probleem met de meeste van deze hulpmiddelen is dat ze moeilijk op grote schaal kunnen worden toegepast.

Maar we hebben misschien een oplossing gevonden. In onze nieuwe studie hebben we vijf korte video’s ontworpen en getest die kijkers “voorbunkeren”, om hen te enten tegen de bedrieglijke en manipulatieve technieken die vaak online worden gebruikt om mensen te misleiden. Onze studie is de grootste in zijn soort en de eerste die dit soort interventie op YouTube test. Vijf miljoen mensen kregen de video’s te zien, waarvan er één miljoen ze bekeken.

We ontdekten dat deze video’s niet alleen in gecontroleerde experimenten mensen helpen om verkeerde informatie te herkennen, maar ook in de echte wereld. Het bekijken van een van onze video’s via een YouTube-advertentie versterkte het vermogen van YouTube-gebruikers om desinformatie te herkennen.

In tegenstelling tot prebunking heeft debunking (of fact-checking) van misinformatie verschillende problemen. Het is vaak moeilijk om vast te stellen wat de waarheid is. Feiten-checks bereiken ook vaak niet de mensen die het meest waarschijnlijk de verkeerde informatie geloven, en mensen zover krijgen dat ze feiten-checks accepteren kan een uitdaging zijn, vooral als mensen een sterke politieke identiteit hebben.

Studies tonen aan dat het online publiceren van fact-checks de effecten van verkeerde informatie niet volledig terugdraait, een fenomeen dat bekend staat als het continue invloedseffect. Tot nu toe hebben onderzoekers moeite gehad om een oplossing te vinden die snel miljoenen mensen kan bereiken.

Het grote idee

De inentingstheorie is het idee dat je psychologische weerstand kunt smeden tegen pogingen om je te manipuleren, net zoals een medisch vaccin een verzwakte versie is van een ziekteverwekker die je immuunsysteem aanzet tot het maken van antilichamen. Prebunking interventies zijn meestal gebaseerd op deze theorie.

De meeste modellen hebben zich gericht op het tegengaan van individuele voorbeelden van verkeerde informatie, zoals berichten over klimaatverandering. De laatste jaren hebben onderzoekers, waaronder wijzelf, echter manieren onderzocht om mensen in te enten tegen de technieken en stijlfiguren die ten grondslag liggen aan veel van de misinformatie die we online zien. Dergelijke technieken zijn onder meer het gebruik van emotieve taal om verontwaardiging en angst uit te lokken, of het tot zondebok maken van mensen en groepen voor een kwestie waar ze weinig tot geen controle over hebben.

Een voorbeeld van een social media post (die we gebruikten als een van de stimuli in onze studie) die gebruik maakt van een valse dichotomie (of vals dilemma), een veelgebruikte manipulatietechniek.

Online spelletjes zoals Cranky Uncle en Bad News behoorden tot de eerste pogingen om deze prebunking methode uit te proberen. Er zijn verschillende voordelen aan deze aanpak. Je hoeft niet op te treden als de arbiter van de waarheid omdat je geen feiten hoeft te controleren van specifieke beweringen die je online ziet. Het stelt u in staat emotionele discussies over de geloofwaardigheid van nieuwsbronnen uit de weg te gaan. En misschien wel het belangrijkste: u hoeft niet te weten welk stuk verkeerde informatie als volgende viral zal gaan.

Een schaalbare aanpak

Maar niet iedereen heeft de tijd of de motivatie om een spel te spelen – dus werkten we samen met Jigsaw (de onderzoekseenheid van Google) aan een oplossing om meer van deze mensen te bereiken. Ons team ontwikkelde vijf prebunking video’s, die elk minder dan twee minuten duurden, met als doel kijkers immuun te maken voor een andere manipulatietechniek of logische denkfout. Als onderdeel van het project hebben we een website gelanceerd waar mensen deze video’s kunnen bekijken en downloaden.

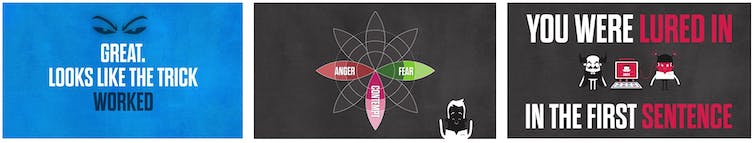

Screenshots van een van de video’s.

We hebben eerst de impact in het lab getest. We hebben zes experimenten uitgevoerd (met in totaal ongeveer 6.400 deelnemers) waarin mensen een van onze video’s of een ongerelateerde controlevideo over vriesbrand hebben bekeken. Daarna, binnen 24 uur na het zien van de video, werden ze gevraagd om een reeks (ongepubliceerde) sociale media content voorbeelden te evalueren die wel of niet gebruik maakten van desinformatie technieken. We ontdekten dat mensen die onze voorinformatievideo’s hadden gezien, significant minder vatbaar waren voor manipulatie dan de controle deelnemers.

Maar bevindingen uit laboratoriumstudies vertalen zich niet noodzakelijk naar de echte wereld. Daarom hebben we ook een veldstudie gedaan op YouTube, ’s werelds op één na meest bezochte website (eigendom van Google), om de effectiviteit van de video-interventies daar te testen.

Voor deze studie richtten we ons op Amerikaanse YouTube-gebruikers ouder dan 18 jaar die eerder politieke inhoud op het platform hadden bekeken. We voerden een advertentiecampagne met twee van onze video’s, en lieten ze zien aan ongeveer 1 miljoen YouTube-gebruikers. Vervolgens gebruikten we de betrokkenheidstool BrandLift van YouTube om mensen die een prebunkingvideo hadden gezien, te vragen één meerkeuzevraag te beantwoorden. De vraag beoordeelde hun vermogen om een manipulatietechniek in een nieuwskop te herkennen. We hadden ook een controlegroep, die dezelfde onderzoeksvraag beantwoordde maar de prebunking video niet zag. We ontdekten dat de prebunking groep 5-10% beter was dan de controlegroep in het correct identificeren van verkeerde informatie, wat aantoont dat deze aanpak de weerbaarheid verbetert, zelfs in een afleidende omgeving zoals YouTube.

Een van de prebunking video’s (“valse dichotomieën”)

Onze video’s zouden minder dan 4 p per bekeken video kosten (dit zou de advertentiekosten van YouTube dekken). Als resultaat van deze studie gaat Google in september 2022 een advertentiecampagne voeren met soortgelijke video’s. Deze campagne zal worden gevoerd in Polen en Tsjechië om desinformatie over vluchtelingen tegen te gaan in de context van de oorlog tussen Rusland en Oekraïne.

Wanneer je veerkracht probeert op te bouwen, is het nuttig om niet te direct te zijn in het vertellen van mensen wat ze moeten geloven, want dat zou iets kunnen triggeren dat psychologische reactantie wordt genoemd. Reactantie betekent dat mensen het gevoel hebben dat hun vrijheid om beslissingen te nemen wordt bedreigd, wat ertoe leidt dat ze hun hakken in het zand zetten en nieuwe informatie afwijzen. De inentingstheorie gaat over mensen in staat stellen om hun eigen beslissingen te nemen over wat ze willen geloven.

Soms kan de verspreiding van samenzweringstheorieën en valse informatie online overweldigend zijn. Maar onze studie heeft aangetoond dat het mogelijk is om het tij te keren. Hoe meer sociale mediaplatforms samenwerken met onafhankelijke wetenschappers om schaalbare, op bewijs gebaseerde oplossingen te ontwerpen, testen en implementeren, hoe groter onze kansen worden om de samenleving immuun te maken voor de aanval van verkeerde informatie.

![]()

Jon Roozenbeek heeft financiering ontvangen van de British Academy (#PF21210010), Google Jigsaw, IRIS Coalition (Britse overheid, #SCH-00001-3391), de Economic and Social Research Council (ESRC, #ES/V011960/1), JITSUVAX (EU Horizon 2020, #964728), Omidyar Network India, de Alfred Landecker Foundation, en WhatsApp.

Sander van der Linden adviseert voor of heeft financiering ontvangen van Google, de EU-commissie, de Verenigde Naties (VN), de Wereldgezondheidsorganisatie (WHO), de Alfred Landecker Foundation, Omidyar Network India, de American Psychological Association, de Centers for Disease Control, de Britse overheid, Facebook, WhatsApp, Edelman, de Gates Foundation, de ESRC, en BBC.

Stephan Lewandowsky ontvangt financiering van het Horizon 2020-programma voor onderzoek en innovatie van de Europese Unie onder subsidieovereenkomst nr. 964728 (JITSUVAX). Hij ontvangt ook financiering van de Australian Research Council via een Discovery Grant aan Ullrich Ecker, van Jigsaw (een technologie-incubator opgericht door Google), van UK Research and Innovation (via het Centre of Excellence, REPHRAIN), en van de Volkswagen Foundation in Duitsland. Hij heeft ook een Advanced Grant van de Europese Onderzoeksraad (nr. 101020961, PRODEMINFO) en ontvangt financiering van de John Templeton Foundation (via het Honesty Project van de Wake Forest University). Hij heeft samengewerkt met de Europese Commissie op het gebied van governance en regulering van sociale media.