Andrey_Popov/Shutterstock

Robots zijn meer en meer aanwezig in ons dagelijks leven. Ze kunnen ongelooflijk nuttig zijn (bionische ledematen, robotgrasmaaiers, of robots die maaltijden leveren aan mensen in quarantaine), of alleen maar vermakelijk (robothonden, dansend speelgoed, en acrobatische drones). Verbeelding is misschien de enige grens aan wat robots in de toekomst zullen kunnen doen.

Wat gebeurt er echter als robots niet doen wat wij willen dat ze doen – of het doen op een manier die schade veroorzaakt? Wat gebeurt er bijvoorbeeld als een bionische arm betrokken raakt bij een auto-ongeluk?

Robotongevallen worden om twee redenen een punt van zorg. Ten eerste zal de toename van het aantal robots natuurlijk leiden tot een toename van het aantal ongevallen waarbij ze betrokken zijn. Ten tweede worden we steeds beter in het bouwen van complexere robots. Als een robot complexer is, is het moeilijker te begrijpen waarom er iets fout is gegaan.

De meeste robots werken op verschillende vormen van kunstmatige intelligentie (AI). AI’s zijn in staat om beslissingen te nemen zoals mensen (hoewel ze objectief gezien goede of slechte beslissingen kunnen nemen). Deze beslissingen kunnen van alles zijn, van het identificeren van een voorwerp tot het interpreteren van spraak.

AI’s worden getraind om deze beslissingen voor de robot te nemen op basis van informatie uit enorme datasets. De AI’s worden dan getest op nauwkeurigheid (hoe goed doen ze wat wij willen dat ze doen) voordat ze de taak krijgen.

AI’s kunnen op verschillende manieren worden ontworpen. Als voorbeeld, denk aan de robotstofzuiger. Hij zou zo ontworpen kunnen worden dat wanneer hij tegen een oppervlak botst, hij in een willekeurige richting teruggaat. Omgekeerd kan hij ontworpen zijn om zijn omgeving in kaart te brengen om obstakels te vinden, alle oppervlakken te bestrijken, en terug te keren naar zijn oplaadbasis. Terwijl het eerste vacuüm input van zijn sensoren opvangt, volgt het tweede die input in een intern kaartsysteem. In beide gevallen neemt de AI informatie op en neemt op basis daarvan een beslissing.

Hoe complexer een robot kan werken, hoe meer soorten informatie hij moet interpreteren. Hij kan ook meerdere bronnen van één soort gegevens beoordelen, zoals, in het geval van auditieve gegevens, een levende stem, een radio, en de wind.

Naarmate robots complexer worden en kunnen handelen op basis van een verscheidenheid aan informatie, wordt het nog belangrijker om te bepalen op basis van welke informatie de robot heeft gehandeld, met name wanneer schade is veroorzaakt.

Lees meer:

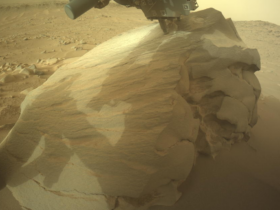

We leren robots om autonoom te evolueren – zodat ze zich kunnen aanpassen aan het leven alleen op verre planeten

Ongelukken gebeuren

Zoals bij elk product kunnen er dingen misgaan met robots, en dat gebeurt ook. Soms is het een intern probleem, bijvoorbeeld dat de robot een stemcommando niet herkent. Soms is het extern – de sensor van de robot was beschadigd. En soms is het beide, zoals de robot die niet ontworpen is om op tapijt te werken en “struikelt”. Bij robotongevallenonderzoek moeten alle mogelijke oorzaken worden bekeken.

Hoewel het vervelend kan zijn als de robot beschadigd raakt wanneer er iets fout gaat, zijn we veel bezorgder wanneer de robot schade toebrengt aan, of er niet in slaagt de schade te beperken voor, een persoon. Bijvoorbeeld als een bionische arm er niet in slaagt een hete drank te pakken, waardoor deze op de eigenaar terechtkomt; of als een zorgrobot er niet in slaagt een noodoproep te registreren wanneer de hulpbehoevende gebruiker is gevallen.

Waarom is het onderzoek naar ongevallen met robots anders dan dat naar ongevallen met mensen? In het bijzonder hebben robots geen motieven. Wij willen weten waarom een robot de beslissing nam die hij nam op basis van de specifieke set inputs die hij had.

In het voorbeeld van de bionische arm, was het een miscommunicatie tussen de gebruiker en de hand? Heeft de robot meerdere signalen door elkaar gehaald? Onverwachts vergrendeld? In het voorbeeld van de persoon die omviel, kon de robot de roep om hulp niet “horen” boven een luide ventilator? Of had hij moeite met het interpreteren van de spraak van de gebruiker?

Als een robot niet goed werkt, moeten we begrijpen waarom.

UfaBizPhoto/Shutterstock

De zwarte doos

Robot ongevallenonderzoek heeft een belangrijk voordeel ten opzichte van menselijk ongevallenonderzoek: er is potentieel voor een ingebouwde getuige. Commerciële vliegtuigen hebben een soortgelijke getuige: de zwarte doos, gebouwd om vliegtuigcrashes te weerstaan en informatie te verschaffen over waarom de crash gebeurde. Deze informatie is ongelooflijk waardevol, niet alleen om incidenten te begrijpen, maar ook om te voorkomen dat ze zich herhalen.

Als onderdeel van RoboTIPS, een project dat zich richt op verantwoorde innovatie voor sociale robots (robots die interactie hebben met mensen), hebben we wat we noemen de ethische zwarte doos gemaakt: een interne registratie van de inputs van de robot en de bijbehorende acties. De ethische zwarte doos is ontworpen voor elk type robot dat hij bewoont en is gebouwd om alle informatie te registreren waarop de robot reageert. Dit kan stem-, visuele of zelfs hersengolfactiviteit zijn.

Wij testen de ethical black box op een verscheidenheid van robots in zowel laboratorium- als gesimuleerde ongevalsomstandigheden. Het is de bedoeling dat de ethische zwarte doos standaard wordt in robots van alle merken en toepassingen.

Lees meer:

Medische robots: hun gezichtsuitdrukkingen zullen mensen helpen hen te vertrouwen

Hoewel de door de ethische zwarte doos geregistreerde gegevens bij een ongeval nog moeten worden geïnterpreteerd, is het van cruciaal belang dat wij in eerste instantie over deze gegevens beschikken om onderzoek te kunnen verrichten.

Het onderzoeksproces biedt de kans om ervoor te zorgen dat dezelfde fouten niet twee keer gebeuren. De ethische zwarte doos is niet alleen een manier om betere robots te bouwen, maar ook om op verantwoorde wijze te innoveren op een opwindend en dynamisch gebied.

![]()

Keri Grieman ontvangt financiering van ESPRC en The Alan Turing Institute.