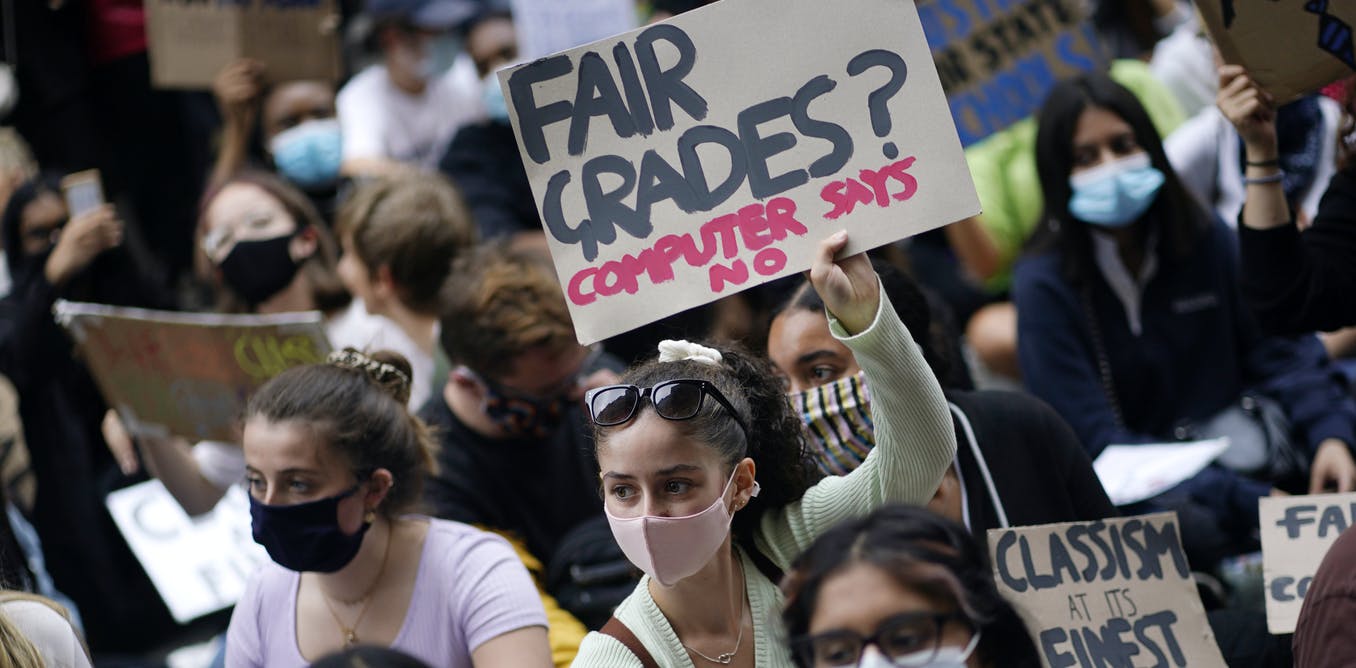

Het recente gebruik van een algoritme om de eindcijfers van middelbare scholieren in Engeland te berekenen, veroorzaakte zoveel publieke woede over de vermeende oneerlijkheid dat het algemeen bekend staat als het ‘A-levels-fiasco’. Als gevolg van de verontwaardiging – en de dreigende dreiging van juridische stappen – werd de regering gedwongen tot een gênante ommezwaai en werden cijfers toegekend op foundation van de beoordeling van de leraar.

Leading Boris Johnson heeft de crisis sindsdien toegeschreven aan wat hij het ‘mutant’-algoritme noemde. Maar dit was geen defect stuk technologie. Doorway veel individuele studenten te markeren om te voorkomen dat hoge cijfers in het algemeen zouden stijgen, deed het algoritme precies wat de overheid wilde. Het feit dat meer kansarme leerlingen werden afgeprijsd was een onvermijdelijk gevolg van het voorrang geven van historische gegevens van een ongelijk onderwijssysteem boven individuele prestaties.

Maar meer dan dit, de saga moet niet worden opgevat als een mislukking van het ontwerp van een specifiek algoritme, noch als het resultaat van incompetentie namens een specifiek overheidsdepartement. Dit is eerder een belangrijke indicator van de datagestuurde methoden waar veel regeringen zich nu naar wenden en de politieke strijd die er waarschijnlijk over zal worden gevochten.

Algoritmische systemen worden vaak om verschillende redenen gepromoot, waaronder beweringen dat ze slimmere, snellere, consistentere en objectievere beslissingen produceren en efficiënter gebruik maken van overheidsmiddelen. Het fiasco van niveau A heeft aangetoond dat dit in de praktijk niet noodzakelijk het geval is. Zelfs als een algoritme een voordeel biedt (snelle, complexe besluitvorming voor een grote hoeveelheid facts), kan het nieuwe problemen opleveren (sociaal-economische discriminatie).

Overal algoritmen

Alleen al in het VK worden of zijn recentelijk meerdere systemen gebruikt om belangrijke beslissingen te nemen die de keuzes, kansen en rechtspositie van bepaalde delen van het publiek bepalen.

Begin augustus stemde het ministerie van Binnenlandse Zaken ermee in om de “streamingtool” voor visa, die ontworpen was om visumaanvragen te sorteren in risicocategorieën (rood, oranje, groen), die aangaf hoeveel verder onderzoek nodig was, te schrappen. Dit volgde op een juridische uitdaging van campagnegroep Foxglove en de liefdadigheidsinstelling Joint Council for the Welfare of Immigrants, die beweerden dat het algoritme discrimineerde op foundation van nationaliteit. Voordat deze zaak bij de rechtbank kon komen, beloofde minister van Binnenlandse Zaken Priti Patel het gebruik van het algoritme end te zetten en zich in te zetten voor een inhoudelijk herontwerp.

De ‘bendematrix’ van de Metropolitan Law enforcement Support is een database die wordt gebruikt om verdachte bendeleden extensive te leggen en geautomatiseerde risicobeoordelingen uit te voeren. Het informeert politie-interventies, waaronder stoppen en zoeken, en arrestatie. Er zijn een aantal zorgen geuit in excess of de mogelijk discriminerende affect, de opname van potentiële slachtoffers van bendegeweld en de niet-naleving van de wetgeving inzake gegevensbescherming.

Veel gemeenten in Engeland gebruiken algoritmen om uitkeringen te controleren en uitkeringsfraude op te sporen. Dr. Joanna Redden van het Info Justice Lab van Cardiff University heeft ontdekt dat een aantal autoriteiten het gebruik van dergelijke algoritmen hebben stopgezet nadat ze problemen hadden ondervonden achieved fouten en vooringenomenheid. Maar ook, veelbetekenend, vertelde ze de Guardian dat er “een gebrek was aan overleg met het publiek en in het bijzonder achieved degenen die het meest getroffen zullen worden doorway het gebruik van deze geautomatiseerde en voorspellende systemen voordat ze worden geïmplementeerd”.

Dit volgt op een belangrijke waarschuwing van Philip Alston, de speciale VN-rapporteur voor serious armoede, dat het VK het risico loopt “als zombie in een digitale welvaartsdystopie te struikelen”. Hij voerde aan dat technologie te vaak wordt gebruikt om de voordelen van mensen te verminderen, intrusief toezicht op te zetten en winst te genereren voor particuliere bedrijven.

De Britse regering heeft ook een nieuw algoritme voorgesteld om te beoordelen hoeveel nieuwe huizen Engelse lokale overheden zouden moeten bouwen. Het impact van dit systeem valt nog te bezien, hoewel het design lijkt te suggereren dat er meer huizen zouden moeten worden gebouwd in zuidelijke plattelandsgebieden, in plaats van in de meer verwachte stedelijke gebieden, satisfied title noordelijke steden. Dit roept ernstige vragen op more than een eerlijke verdeling van de middelen.

Waarom is dit van belang?

Het gebruik van algoritmische systemen door overheden om beslissingen te nemen die een aanzienlijke impact hebben op ons leven, wijst op een aantal cruciale developments bij de overheid. Algoritmische systemen vergroten niet alleen de snelheid en schaal waarop beslissingen kunnen worden genomen, maar veranderen ook de manier waarop die beslissingen worden genomen en de vormen van publieke controle die mogelijk zijn.

Dit wijst op een verschuiving in het perspectief van en de verwachtingen van de overheid 10 aanzien van verantwoording. Algoritmische systemen zijn ondoorzichtige en complexe ‘zwarte dozen’ waarmee krachtige politieke beslissingen kunnen worden genomen op foundation van wiskundige berekeningen, op manieren die niet altijd duidelijk zijn gekoppeld aan wettelijke vereisten.

Alleen al deze zomer zijn er ten minste drie spraakmakende juridische uitdagingen geweest voor het gebruik van algoritmische systemen doorway overheidsinstanties, fulfilled betrekking tot het A-niveau en visumstreamingsystemen, evenals de COVID-19-test- en traceertool van de overheid. Evenzo werd het gebruik van gezichtsherkenningssoftware door de politie van Zuid-Wales doorway het Hof van Beroep onwettig verklaard.

Hoewel het doel en de aard van elk van deze systemen verschillend zijn, hebben ze gemeenschappelijke kenmerken. Elk systeem is geïmplementeerd zonder voldoende toezicht of duidelijkheid over de rechtmatigheid ervan.

Het falen van overheidsinstanties om ervoor te zorgen dat algoritmische systemen verantwoordelijk zijn, is in het slechtste geval een opzettelijke poging om democratische processen te belemmeren doorway algoritmische systemen af te schermen van publieke controle. En in het beste geval vertegenwoordigt het een zeer nalatige houding ten opzichte van de verantwoordelijkheid van de overheid om zich aan de rechtsstaat te houden, transparantie te bieden en te zorgen voor eerlijkheid en de bescherming van mensenrechten.

Satisfied dit in het achterhoofd is het van belang dat we verantwoording eisen van de overheid als deze meer gebruik maakt van algoritmen, zodat we democratische controle behouden over de richting van onze samenleving en onszelf.

Adam Harkens wordt gefinancierd doorway Volkswagenstiftung voor zijn werk aan de Lethal4JUSTICE? job (‘Beslissen more than, door en samen fulfilled algoritmische besluitvormingssystemen’), aan de Universiteit van Birmingham. Dit venture analyseert kritisch algoritmische besluitvorming in het strafrechtsysteem vanuit meerdere elkaar kruisende disciplinaire perspectieven.