Nikodash/Shutterstock

In het Verenigd Koninkrijk had een kwart van de mensen die zich van het leven beroven de week ervoor contact met een gezondheidswerker, en de meesten hebben de afgelopen maand met iemand gesproken. Toch blijft het uiterst moeilijk om het zelfmoordrisico van patiënten in te schatten.

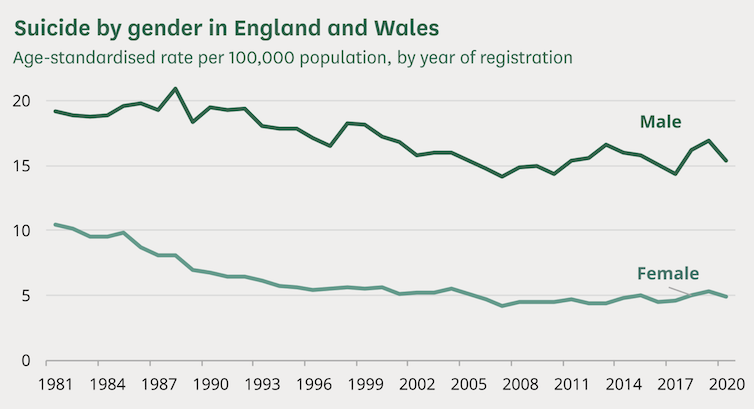

Er waren 5.219 geregistreerde sterfgevallen door zelfmoord in Engeland in 2021. Hoewel het aantal zelfmoorden in Engeland en Wales sinds 1981 met ongeveer 31% is gedaald, vond het grootste deel van deze daling plaats vóór 2000. Zelfmoord komt drie keer vaker voor bij mannen dan bij vrouwen, en deze kloof is in de loop der tijd groter geworden.

Zelfmoordstatistieken in Engeland en Wales van 1981 tot 2021.

House of Commons – Suicide Statistics Research Briefing, 12 oktober 2021.

Een studie uitgevoerd in oktober 2022, geleid door het Black Dog Institute van de Universiteit van New South Wales, vond dat kunstmatige intelligentie (AI) modellen beter presteerden dan klinische risicobeoordelingen. De studie onderzocht 56 studies van 2002 tot 2021 en ontdekte dat AI 66% van de mensen die zelfmoord zouden plegen correct voorspelde en 87% van de mensen die dat niet zouden doen. Ter vergelijking, traditionele scoringsmethoden uitgevoerd door gezondheidswerkers zijn slechts iets beter dan willekeurig.

AI wordt op grote schaal onderzocht in andere medische domeinen zoals kanker. Ondanks hun belofte moeten AI-modellen voor geestelijke gezondheid echter nog op grote schaal worden gebruikt in klinische settings.

Waarom zelfmoord voorspellen zo moeilijk is

Uit een studie uit 2019 van het Karolinska Institutet in Zweden blijkt dat vier traditionele schalen die worden gebruikt om het zelfmoordrisico te voorspellen na recente episodes van zelfbeschadiging slecht presteren. De uitdaging van zelfmoordvoorspelling komt voort uit het feit dat de intentie van een patiënt snel kan veranderen.

In de richtsnoeren over zelfbeschadiging die door gezondheidswerkers in Engeland worden gebruikt, staat uitdrukkelijk dat instrumenten en schalen voor de beoordeling van het zelfmoordrisico niet mogen worden gebruikt. In plaats daarvan moeten professionals gebruik maken van een klinisch interview. Artsen voeren weliswaar gestructureerde risicobeoordelingen uit, maar deze worden gebruikt om de gesprekken te optimaliseren in plaats van een schaal te gebruiken om te bepalen wie behandeling krijgt.

Het risico van AI

De studie van het Black Dog Institute liet veelbelovende resultaten zien, maar als 50 jaar onderzoek naar traditionele (niet-AI) voorspelling methoden opleverde die slechts iets beter waren dan willekeurig, moeten we ons afvragen of we AI wel moeten vertrouwen. Wanneer een nieuwe ontwikkeling ons iets geeft wat we willen (in dit geval betere zelfmoordrisicobeoordelingen) kan het verleidelijk zijn geen vragen meer te stellen. Maar we kunnen het ons niet veroorloven deze technologie te overhaasten. De gevolgen van een fout zijn letterlijk van levensbelang.

Er zal nooit een perfecte risicobeoordeling zijn.

Chanintorn.v/Shutterstock

AI-modellen hebben altijd beperkingen, waaronder de manier waarop hun prestaties worden geëvalueerd. Zo kan het gebruik van nauwkeurigheid als metriek misleidend zijn als de dataset onevenwichtig is. Een model kan 99% nauwkeurigheid bereiken door altijd te voorspellen dat er geen risico op zelfmoord zal zijn als slechts 1% van de patiënten in de dataset een hoog risico heeft.

Het is ook essentieel om AI-modellen te beoordelen op andere gegevens dan waarop ze zijn getraind. Dit is om overfitting te voorkomen, waarbij modellen kunnen leren om resultaten van trainingsmateriaal perfect te voorspellen, maar moeite hebben om met nieuwe gegevens te werken. Modellen kunnen tijdens de ontwikkeling foutloos hebben gewerkt, maar bij echte patiënten verkeerde diagnoses stellen.

AI bleek bijvoorbeeld te veel aan te sluiten bij chirurgische markeringen op de huid van een patiënt bij gebruik om melanoom (een type huidkanker) op te sporen. Artsen gebruiken blauwe pennen om verdachte letsels te markeren, en de AI leerde deze markeringen te associëren met een grotere kans op kanker. Dit leidde in de praktijk tot verkeerde diagnoses wanneer blauwe markeringen niet werden gebruikt.

Het kan ook moeilijk zijn om te begrijpen wat AI-modellen hebben geleerd, zoals waarom het een bepaald risiconiveau voorspelt. Dit is een veel voorkomend probleem bij AI-systemen in het algemeen, en heeft geleid tot een heel onderzoeksgebied dat bekend staat als verklaarbare AI.

Het Black Dog Institute vond dat 42 van de 56 geanalyseerde studies een hoog risico op bias hadden. In dit scenario betekent een bias dat het model het gemiddelde zelfmoordpercentage over- of onderschat. Bijvoorbeeld, de gegevens hebben een zelfmoordpercentage van 1%, maar het model voorspelt een percentage van 5%. Een hoge bias leidt tot verkeerde diagnoses, waarbij patiënten met een hoog risico ontbreken of aan patiënten met een laag risico een te hoog risico wordt toegekend.

Deze vertekeningen komen voort uit factoren zoals de selectie van deelnemers. Verschillende studies hadden bijvoorbeeld hoge case-control ratio’s, wat betekent dat het percentage zelfmoorden in de studie hoger was dan in werkelijkheid, zodat het AI-model waarschijnlijk te veel risico aan patiënten toekende.

Veelbelovende vooruitzichten

De modellen gebruikten meestal gegevens uit elektronische patiëntendossiers. Maar sommige bevatten ook gegevens uit interviews, zelfrapportages en klinische aantekeningen. Het voordeel van het gebruik van AI is dat het sneller en efficiënter kan leren van grote hoeveelheden gegevens dan mensen, en patronen kan herkennen die door overwerkte gezondheidswerkers worden gemist.

Hoewel er vooruitgang wordt geboekt, is de AI-benadering van zelfmoordpreventie nog niet klaar om in de praktijk te worden gebruikt. Onderzoekers zijn al bezig om veel van de problemen met AI zelfmoordpreventiemodellen aan te pakken, zoals hoe moeilijk het is om uit te leggen waarom algoritmen hun voorspellingen deden.

Zelfmoordvoorspelling is echter niet de enige manier om het aantal zelfmoorden te verminderen en levens te redden. Een nauwkeurige voorspelling helpt niet als die niet leidt tot een effectieve interventie.

Op zichzelf zal zelfmoordvoorspelling met AI niet elke dood voorkomen. Maar het kan professionals in de geestelijke gezondheidszorg een nieuw instrument geven om voor hun patiënten te zorgen. Het kan net zo levensveranderend zijn als geavanceerde hartchirurgie als het alarm slaat bij over het hoofd geziene patiënten.

Als u worstelt met zelfmoordgedachten, kunnen de volgende diensten u steun bieden:

In het VK en Ierland – bel Samaritans UK op 116 123.

In de VS – bel de National Suicide Prevention Lifeline op 1-800-273-TALK (8255) of IMAlive op 1-800-784-2433.

In Australië – bel Lifeline Australia op 13 11 14.

In andere landen – bezoek IASP of Suicide.org om een hulplijn in uw land te vinden.

![]()

Joseph Early werkt niet voor, geeft geen advies, heeft geen aandelen in of ontvangt geen financiering van een bedrijf of organisatie die baat heeft bij dit artikel, en heeft geen relevante banden bekendgemaakt buiten zijn academische aanstelling.